ARTDEPARTMENT

ARTDEPARTMENT

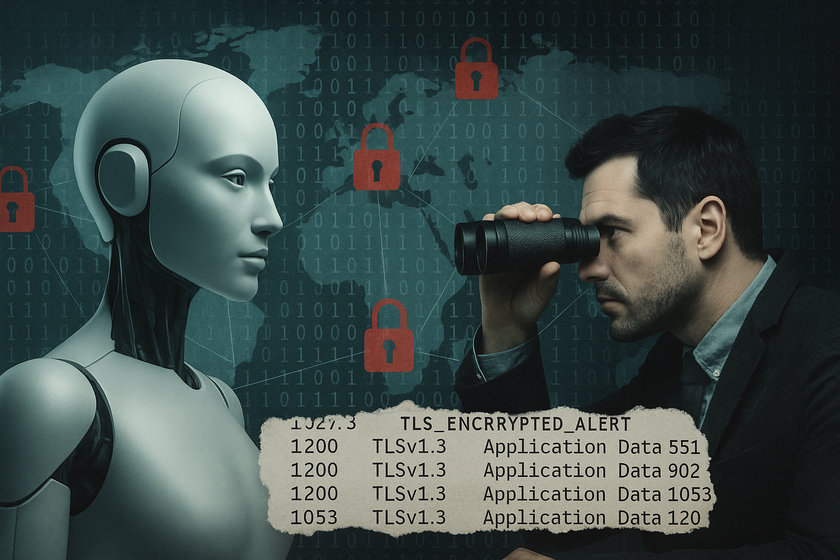

Hace unos días, un equipo de investigadores de Microsoft anunció un hallazgo que ha sorprendido tanto en el sector de la IA como en el de la ciberseguridad: la existencia de una clase de ciberataque denominado 'Whisper Leak' (poco así como 'Filtración por susurros'), capaz de inferir el tema de las conversaciones entre usuarios y modelos de jerga —como ChatGPT o Gemini— incluso cuando esas comunicaciones están protegidas por enigmático TLS.

El descubrimiento no implica un decisión en el enigmático mismo, sino lo que se denomina una filtración por canal fronterizo (o side-channel leak): una forma de espionaje que no rompe la encriptación, sino que aprovecha las señales indirectas del tráfico de red —como el tamaño de los paquetes y los intervalos de tiempo entre ellos— para deducir lo que ocurre "detrás del candado".

El estudio revela que la vulnerabilidad es sistémica y transversal: afecta a numerosos modelos comerciales, incluidos los de grandes proveedores como OpenAI, Anthropic, Google, AWS, DeepSeek y Alibaba.

Un ataque por canal fronterizo no accede al contenido de un mensaje, sino que observa sus patrones. En criptografía clásica, estos ataques se utilizaban para robar claves analizando el consumo eléctrico de un chip o las variaciones de tiempo durante una operación.

En el caso de los modelos de jerga, el canal fronterizo surge del propio modo en que los sistemas generan y transmiten texto: de forma secuencial y en tiempo actual. Cada palabra o fragmento (token) que el maniquí genera se envía al becario inmediatamente, para ofrecer una experiencia 'fluida'.

Aunque todo el tráfico está enigmático, el tamaño y la cadencia de esos fragmentos no se ocultan. Al igual que escuchar el ritmo de una conversación sin entender las palabras, un atacante puede cachear (haciendo uso, a su vez, de IAs específicamente entrenadas) ciertos patrones estadísticos que revelan el tema tratado.

Los investigadores de Microsoft idearon un cuestionario con un objetivo concreto: comprobar si podían identificar conversaciones sobre un tema sensible —en este caso, "la moralidad del lavado de patrimonio"— simplemente observando el tráfico enigmático. Para ello:

En palabras de los autores: "TLS número el contenido, pero no los metadatos. Y esos metadatos son suficientes para adivinar el contexto"

El resultado fue intranquilizante: en 17 de los 28 modelos probados, los clasificadores alcanzaron más del 98 % de precisión. Incluso bajo condiciones realistas —una conversación sensible entre 10.000 normales— algunos modelos permitieron una detección perfecta del 5 al 20 % de las conversaciones sobre el tema objetivo, sin falsos positivos.

En términos prácticos, esto significa que un observador de red (por ejemplo, un proveedor de Internet o un gobierno dominante) podría identificar con gran certeza cuándo un becario está hablando sobre temas considerados 'delicados' —como política, protestas o periodismo— sin pobreza de romper el enigmático.

Según Microsoft, varios proveedores ya han implementado mitigaciones efectivas, entre ellos:

Estos servicios añadieron un campo de ofuscación en sus API, que introduce texto fortuito o tokens falsos en las respuestas para distorsionar los patrones de tamaño y tiempo. Esta técnica, inspirada en una decisión previa de Cloudflare, reduce la efectividad del ataque "a niveles que ya no representan un peligro práctico".

Los propios investigadores probaron tres estrategias defensivas:

Todas reducen la aptitud del ataque, pero ninguna lo elimina totalmente sin matar rendimiento o latencia.

Imagen | Marcos Merino mediante IA

En Genbeta | Un puñado de documentos maliciosos baste para 'intoxicar' un maniquí de IA y alterar sus respuestas, según este estudio de Anthropic

Compartir este artículo

Consultoria Personalizada

¡Si aun no tienes presencia en internet o

necesitas ayuda con tus proyectos, por favor, escribenos!