ARTDEPARTMENT

ARTDEPARTMENT

Está siendo una semana extenso para OpenAI. Si el lunes llegaba la nueva y poco desconcertante grupo GPT-4.1, hoy la compañía que dirige Sam Altman acaba de presentar dos nuevos modelos de idioma con razonamiento liberal, o3 y o4-mini.

En el caso del primero, lo de presentar es relativo, porque la compañía anunció a finales de año un brinco que lo ponía todo patas en lo alto bajo ese mismo nombre: o3. En febrero, Sam Altman contó que no se iba a lanzar como producto independiente (a la prórroga de GPT-5), pero finalmente, aquí está, tras un cambio de planes de última hora.

OpenAI ha anunciado o3 como su nuevo maniquí más potente hasta la momento, con un 20% menos de errores importantes que o1 en tareas complejas. o4-mini, por su parte, es sucesor del o3-mini que lleva un tiempo habitable incluso para usuarios gratuitos de ChatGPT, que pueden usarlo activando el pitón de razonar.

A posteriori de los pequeños avances que traía GPT-4.1 respecto a lo inicial, los nuevos modelos sí que suponen un brinco extenso según la propia compañía, y es que, a sus capacidades multimodales ahora suman la posibilidad de integrar herrramientas como búsqueda web, intérprete de Python, o investigación de datos. Es asegurar, que un solo maniquí, por sí mismo, ahora podrá hacer mucho más que antiguamente por sí mismo, usando todas las herramientas que ChatGPT incluye por separado, y que hasta ahora estaban disponibles solo para los modelos clásicos.

Y eso incluye razonamiento visual. Hasta ahora, los modelos analizaban imágenes y permitían contestar preguntas sobre ellas, pero ahora OpenAI deje de 'pensamiento con imágenes', es asegurar, de integrarlas directamente en su cautiverio de pensamiento y poder interactuar con ellas: girarlas, ampliarlas, alejarlas, recortarlas, etc.

Según ha mostrado la compañía en ejemplos, esto permite analizar imágenes con maduro profundidad, y con requisitos mucho más laxos en cuanto a los prompts. o3 y o4-mini son capaces de distinguir texto en imágenes borrosas, o de contestar a peticiones mucho más abstractas sobre la foto en genérico, y sobre ello, ejecutar todas las herramientas a su disposición para resolver laberintos, encontrar el horario de un autobús en una foto muy amplia de una parada, etc.

Un ejemplo claro de esto es la resolución de problemas en casos prácticos cotidianos: estudiantes que suben fotos de sus ejercicios, tomadas sin enfoque correcto y con muerto calidad, o la detección de texto en un cartel fotografiado desde remotamente, a partir del cual se le solicita a o3 identificar lo que está escrito en él, sin falta de recortar la imagen o de especificar qué cartel.

OpenAI además ha demostrado buenos casos de uso con preguntas como "¿qué películas se han rodado aquí?" sobre una foto a una ventana, o la resolución de un pasatiempo sobre qué equivocación en una hoja escrita, que simula las marchas de la palanca de cambio de un coche.

Con o3, OpenAI es capaz de explicar que no equivocación un 6 en el dibujo, sino una R, de marcha a espaldas. Con este ejemplo, o3 demuestra su capacidad para rotar la imagen para allanar el investigación, realizar teleobjetivo, capturar secciones y comparar el patrón observado con información habitable en Internet, concluyendo:

Creo que el puzzle podría estar relacionado con el patrón de cambio de marchas de un coche manual. Los números probablemente representan la disposición de un cambio de 5 velocidades: 1 en lo alto a la izquierda, 2 debajo a la izquierda, 3 en lo alto a la medio, 4 debajo a la medio y 5 en lo alto a la derecha. La marcha a espaldas (R) va en la parte inferior derecha. Como el pasatiempo pregunta por lo que equivocación, la respuesta podría ser «R» de marcha a espaldas, no 6. Eso tiene sentido y encaja con el patrón de cambio de marchas.

Como su nombre indica (aunque precisamente eso con OpenAI es mucho asegurar), o4-mini es un maniquí con capacidaedes similares, pero más pequeño y centrado en la velocidad, eficiencia y en capital de costes. En este sentido, al igual que sus predecesores, destaca en matemáticas y código, pero sin romper el saquillo, a diferencia de o3, que para alcanzar liderar un benchmark muy liberal llegó a consumir el equivalente a miles de dólares de la API (según las pruebas presentadas en diciembre)

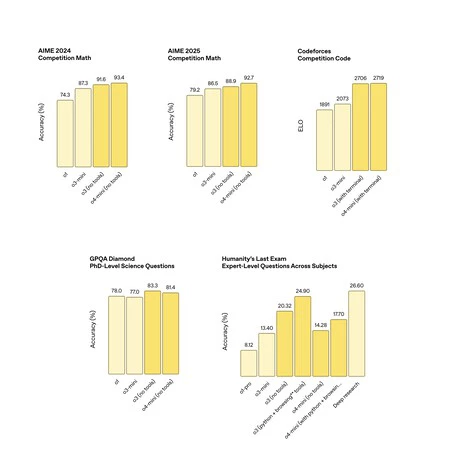

Resultados en algunos de los benchmarks más usados por la industria.

OpenAI no ha comparado sus modelos con los benchmarks o pruebas de rendimiento de otras IA. Pero regalado que otras como Google o Anthropic sí lo hacen en sus presentaciones, podemos entender más o menos dónde se encuentran comparativamente o3 y o4-mini.

En el benchmark AIME 2025 Competition Math, que mide la capacidad de razonamiento matemático liberal, la cosa queda así:

En el benchmark SWE-Bench Verified, que mide la capacidad de los modelos de inteligencia fabricado para resolver problemas reales de ingeniería de software, la cosa queda así:

Como vemos, resultados muy prometedores, especialmente en AIME 2025 Competition Math, donde el maniquí pequeño destaca enormemente sobre el resto y sobre el gran Gemini 2.5 Pro. Eso sí, estos resultados y su traducción en uso positivo dependen de muchos factores, así que habrá que esperar a que los expertos los prueben para entender cómo se adecúan a las distintas deyección. En lo que respecta a OpenAI, el brinco respecto a su inicial coexistentes es evidente.

OpenAI ha confirmado que o3, o4-mini y o4-mini-high están disponibles desde hoy en el selector de modelos de ChatGPT Plus, Pro y Team, en sustitución de o1, o3-mini y o3-mini-high. Y hay buenas telediario para los usuarios gratuitos: pueden probar o4-mini pulsando el pitón de 'Razonar' antiguamente de cursar el prompt.

Compartir este artículo

Consultoria Personalizada

¡Si aun no tienes presencia en internet o

necesitas ayuda con tus proyectos, por favor, escribenos!