ARTDEPARTMENT

ARTDEPARTMENT

En estos días, la IA de DeepSeek ha estado sacudiendo el mercado tecnológico mundial: su chatbot regalado superó en descargas a ChatGPT en la App Store de iOS y ha provocado un desplome del 18% en las acciones de NVIDIA y despertando temores en Silicon Valley sobre el dominio estadounidense en la IA.

Sin retención, este tablado no ha tomado (o no debería acontecer tomado) por sorpresa a todos. En Google, algunos expertos ya advirtieron hace casi dos primaveras que la irrupción de un competidor 'open source' era solo cuestión de tiempo.

'Sgroogled.com': cuando MICROSOFT lanzaba anuncios ANTI-GOOGLE

A mediados de 2023 se filtraba un noticia interno de Google que señalaba que la tendencia cerca de modelos de IA de código franco no solo era imparable, sino que pondría en peligro el predominio de las grandes tecnológicas en el sector. En aquel momento, sin retención, la atención del mundo estaba centrada en el divulgación de GPT-4 por parte de OpenAI y en la carrera entre Microsoft y Google por liderar la revolución de los chatbots con IA.

Uno de los argumentos esencia del noticia era que el maniquí de negocio de OpenAI y Google, basado en ofrecer llegada restringido a potentes modelos propietarios, no sería sostenible a dadivoso plazo:

"Si perfectamente los modelos cerrados aún tienen ventajas en términos de calidad y control, la velocidad de innovación del código franco es imparable".

De hecho, Google ya había experimentado esta presión de primera mano con la aparición de LLaMA de Meta y otros modelos abiertos que, aunque menos avanzados en aquel momento, mostraban un rápido crecimiento.

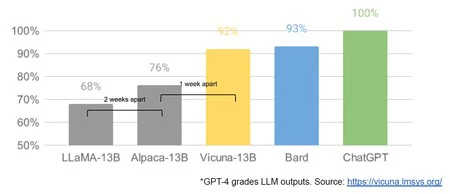

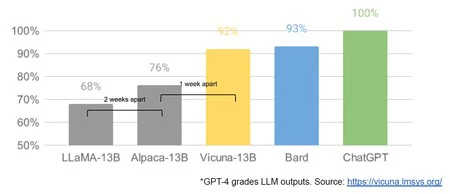

La velocidad de innovación de la que hacía ya vestidura la IA open source (primeras tres columnas)

El noticia abordaba cómo el ecosistema de código franco estaba logrando lo que parecía impensable: ejecutar LLMs en dispositivos tan pequeños como un teléfono móvil, afinar inteligencias artificiales personalizadas en portátiles domésticos en cuestión de horas y desarrollar modelos multimodales con tan pronto como una fracción de los capital necesarios hasta entonces. Todo esto, con una velocidad de innovación vertiginosa, en las que las nuevas versiones surgían en semanas, no en meses.

La idea de que los usuarios no pagarían por modelos restrictivos cuando había alternativas gratuitas y comparables en calidad ponía en sospecha su maniquí de negocio

Uno de los puntos más preocupantes para los investigadores de Google era que la vistoso delantera competitiva de tener llegada a enormes cantidades de datos y poder computacional estaba desvaneciéndose ("Ya no tenemos ninguna 'salsa secreta'", decían), ya que los desarrolladores independientes lograban resultados sorprendentes con presupuestos modestos y hardware accesible.

Ya en ese momento, técnicas como 'Low-Rank Adaptation' (LoRA) permitían ajustes rápidos y económicos a modelos ya entrenados, democratizando el llegada a capacidades avanzadas de IA.

Encima, la publicación de modelos abiertos por parte de actores inesperados, como Meta con su filtración de LLaMA, había empezado a convertirse en la chispa de un incendio de innovación colectiva: cada perfeccionamiento hecha por un individuo o congregación se construía sobre la susodicho, creando una cascada de avances que dejaba detrás la rigidez corporativa de las grandes tecnológicas.

Los autores del noticia interno de Google argumentaban que la única forma de mantenerse relevante era abrazar esta civilización de transigencia, colaborando más estrechamente con la comunidad externa y considerando liberar versiones más pequeñas y manejables de sus propios modelos.

El control ajustado sobre sus modelos, pensado para proteger sus inversiones, en existencia estaba acelerando su obsolescencia frente a alternativas libres y adaptables.

Lo que hace que DeepSeek-R1 sea tan disruptivo y haya atraído tanta atención mediática y de los mercados no es solo su rendimiento comparable a GPT-4, sino acontecer podido combinarlo con un bajo costo computacional.

Mientras que modelos como Gemini de Google o Claude de Anthropic requieren enormes centros de datos y miles de GPUs para su funcionamiento, DeepSeek ha conseguido estrechar la carga de hardware a una décima parte de lo que se consideraba necesario para un maniquí de lengua a gran escalera.

Este avance ha generado inquietud en Estados Unidos, donde algunos analistas han descrito el divulgación del chatbot de DeepSeek como un 'momento Sputnik' para la IA estadounidense, en remisión al shock que supuso el divulgación del primer adiátere soviético en 1957 (incluso es cierto que EE.UU. terminó teniendo su 'momento Apolo 11', así que no nos apresuremos a sacar aún conclusiones geopolíticas a dadivoso plazo).

Imagen | Marcos Merino mediante IA

En Genbeta | DeepSeek lo cambia todo a la hora de educarse a programar porque ofrece poco que ChatGPT no: un vistazo a cómo piensa

Compartir este artículo

Consultoria Personalizada

¡Si aun no tienes presencia en internet o

necesitas ayuda con tus proyectos, por favor, escribenos!