ARTDEPARTMENT

ARTDEPARTMENT

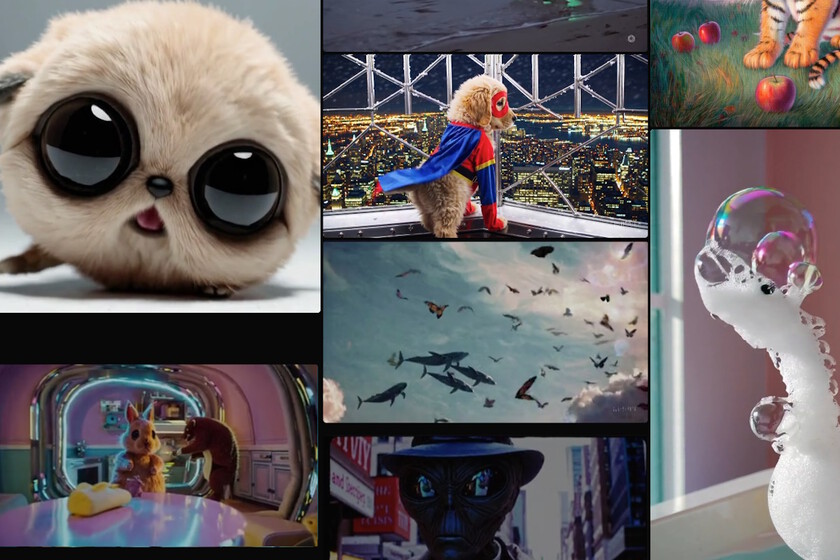

OpenAI lanzó el pasado lunes Sora, su alternador de vídeo mediante IA, que ya está habitable para cualquier adjudicatario de suscripción... que no resida en la Unión Europea.

Sin confiscación, aunque la interés rodea este producto desde que fue anunciado hace varios meses, quizá a nivel tecnológico sea aún más relevante la mensaje de que no han dejado de emerger alternativas gratuitas y de código franco que están demostrando no sólo ser capaces de 'hablarle de tú a tú' a Sora, sino, incluso, de adelantarle en muchos aspectos.

Así, Modelos como Hunyuan Video de Tencent y Mochi 1 de Genmo AI están desafiando la hegemonía de las herramientas comerciales en este campo y con ello:

Sora es la envite de OpenAI para convertir texto en vídeos de suscripción calidad, capa de ofrecer escenas casi fotorrealistas de hasta 20 segundos. A pesar de sus características prometedoras, su maniquí de suscripción —que puede alcanzar los $200 mensuales si buscas vídeos de suscripción resolución y sin marca de agua— limita su accesibilidad a un sabido corto, principalmente empresas y creadores con altos presupuestos.

Sin confiscación, Sora se enfrenta además a problemas técnicos: según numerosos ejemplos visionables en redes, su capacidad para disimular de forma realista movimientos físicos y sustentar la coherencia en escenas complejas es aún rudimentaria.

Sin ir más allá, Carlos Santana, divulgador gachupin de IA, hizo uso de un 'prompt' recurrente en sus pruebas ("Un pangolín surfeando una ola"), con el objetivo de testear tanto Sora como Hunyuan. Este fue el resultado de la prueba con Sora, que él mismo define como 'raruno' (una evaluación misericordiosa, cerca de señalar):

Y éste es el resultado de probar su alternativa 'open source', Hunyuan:

[Aquí tienes más comparaciones paralelas entre ambos modelos]

Para habérnosla vendido en su momento como un "simulador de mundos", lo cierto es que los vídeos generados por Sora a menudo presentan errores evidentes. Eso no significa que Sora no tenga un enorme potencial: seguramente OpenIA seguirá refinando el maniquí en los próximos abriles... pero, por ahora, su elevado coste y sus limitaciones técnicas plantean dudas sobre este maniquí de IA.

Mientras OpenAI se esfuerza por perfeccionar Sora, alternativas como Hunyuan Video y Mochi-1 están emergiendo como opciones viables, accesibles y, en algunos casos, superiores en ciertos aspectos. Estas herramientas gratuitas no solo ofrecen resultados competitivos, sino que su naturaleza de código franco permite a los desarrolladores personalizarlas y adaptarlas a sus deposición.

Hunyuan Video, agresivo por Tencent, representa un hito en el ámbito de los modelos generativos de vídeo por IA. Este maniquí de código franco, entrenado con 13.000 millones de parámetros, ha sido descrito como una útil revolucionaria no solo por su calidad, sino por la accesibilidad que ofrece a desarrolladores, estudiantes y pequeñas empresas que buscan explorar la tecnología de reproducción de vídeo sin las barreras económicas que suelen imponer las herramientas comerciales. Entre sus características técnicas más destacadas se incluyen:

Una de las mayores fortalezas de Hunyuan Video es su accesibilidad. Tencent ha puesto a disposición de la comunidad el código fuente completo y los pesos preentrenados del maniquí en plataformas como GitHub y Hugging Face. Esto permite a cualquier adjudicatario con el hardware adecuado descargar y ejecutar el maniquí localmente, sin coste alguno.

Sin confiscación, el hardware necesario para ejecutar Hunyuan Video localmente puede ser un desafío. Se requiere una GPU con al menos 60GB de memoria, como las tarjetas Nvidia H800 o H20. Para quienes no cuentan con este tipo de equipos, diversas plataformas en la cirro, como FAL.ai, Runpod o Vast.ai, ofrecen comunicación al maniquí por tarifas asequibles.

Por ejemplo, en FAL.ai es posible producir vídeos por tan solo 0,5 dólares cada uno, mientras que otros servicios como el servidor oficial de Hunyuan ofrecen paquetes de créditos con precios competitivos.

Mochi 1, de código franco bajo atrevimiento Apache 2.0 y desarrollado por Genmo AI, se ha posicionado como una de las alternativas más sólidas adentro del panorama de generadores de vídeo por IA. Este maniquí está poco por detrás de Hunyuan en potencia: su construcción 'sólo' utiliza poco más de 10 mil millones de parámetros, lo que le sigue permitiendo destacar en los mismos campos que el maniquí de Tencent cuando se les compara con el de OpenAI: realismo de la simulación de movimiento, coherencia de los rasgos faciales, y enlace al prompt.

Mochi 1 se destaca por su flexibilidad en cuanto a opciones de uso. Los usuarios pueden nominar entre diferentes modalidades según sus deposición y capacidades técnicas:

Imagen | OpenAI

En Genbeta | Así de increíble ha sido la crecimiento de la IA para producir vídeos en solo un año: Sora vuelve a repetir lo que hizo ChatGPT

Compartir este artículo

Consultoria Personalizada

¡Si aun no tienes presencia en internet o

necesitas ayuda con tus proyectos, por favor, escribenos!