ARTDEPARTMENT

ARTDEPARTMENT

OpenAI ha vuelto a sacudir el panorama tecnológico con la presentación de su nueva tribu de modelos de jerigonza: GPT-4.1, GPT-4.1 mini y GPT-4.1 nano. Este extensión marca un brinco significativo respecto a versiones anteriores y refleja la postura decidida de la compañía por optimizar IA para realizar tareas del mundo actual, especialmente en el ámbito del ampliación de software y la creación de agentes autónomos.

Durante una transmisión en directo, OpenAI ha entregado a conocer que los modelos GPT-4.1 han sido diseñados con mejoras notables en tres frentes esencia: codificación, seguimiento de instrucciones y comprensión de contextos largos. Estos modelos no están disponibles en la web o la app de ChatGPT —al menos por ahora—, sino exclusivamente a través de la API de OpenAI, lo que los posiciona como herramientas orientadas directamente al ampliación profesional.

La variedad incluye:

Uno de los avances más impresionantes es su ventana de contexto de hasta un millón de tokens, lo que equivale a más de 750.000 palabras, muy por encima de los 128.000 tokens de GPT-4o. Esto permite a los nuevos modelos analizar grandes volúmenes de texto, código o documentos en una sola consulta.

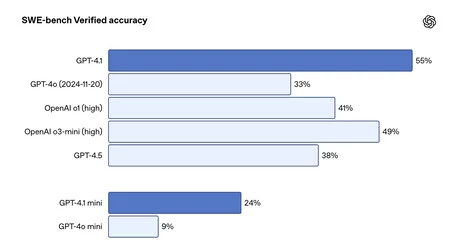

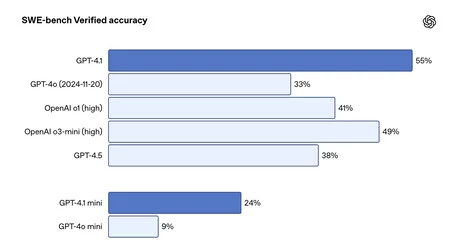

GPT-4.1 ha sido optimizado específicamente para el ampliación de software. Supera ampliamente a sus predecesores en pruebas como SWE-bench Verified, alcanzando una precisión del 54,6%, frente al 33,2% de GPT-4o y al 38% de GPT-4.5. Adicionalmente, produce menos ediciones innecesarias, sigue mejor los formatos de diferencia de código (diff) y genera mejores respuestas para tareas frontend.

Esas cifras, sin confiscación, están tenuemente por debajo de las puntuaciones anunciadas por Google y Anthrope para Gemini 2.5 Pro (63,8%) y Claude 3.7 Sonnet (62,3%), respectivamente, en el mismo benchmark..

El maniquí incluso muestra una prosperidad trascendental en el seguimiento de instrucciones, crucial para agentes autónomos y aplicaciones empresariales. En evaluaciones como MultiChallenge y IFEval, GPT-4.1 ha superado a sus antecesores con diferencias de hasta 10,5% y 6,4%, respectivamente.

Gracias a pruebas como Video-MME, OpenAI-MRCR y Graphwalks, se ha demostrado que GPT-4.1 no solo puede manejar grandes cantidades de texto, sino incluso entender relaciones complejas y recuperar información específica en contextos extensos. Esto lo hace ideal para áreas como el examen judicial, financiero o la subvención al cliente.

Por ahora, los modelos GPT-4.1 no están disponibles directamente en ChatGPT. Sin confiscación, OpenAI ha anunciado que muchas de sus mejoras ya han sido integradas progresivamente en GPT-4o, el maniquí por defecto del chatbot. Asimismo, se planea eliminar el maniquí GPT-4.5 el 14 de julio de 2025, en atención del más capaz y moderado GPT-4.1.

Los nuevos modelos GPT-4.1 están pensados exclusivamente para desarrolladores y se accede a ellos a través de la API de OpenAI. Uno de sus grandes atractivos es su eficiencia económica, que prosperidad considerablemente frente a versiones anteriores.

El maniquí principal, GPT-4.1, tiene un coste de $2 por millón de tokens de entrada y $8 por millón de tokens de salida, posicionándose como una opción robusta para tareas complejas, pero aún más asequible que su predecesor GPT-4o.

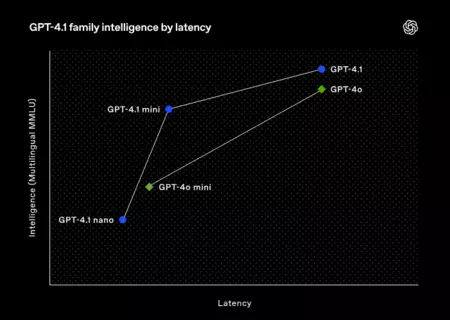

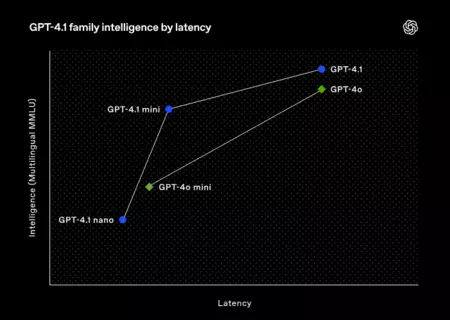

Por su parte, GPT-4.1 mini es una traducción más liviana, optimizada para tareas exigentes pero con último latencia. Su uso implica un coste de $0,40 por millón de tokens de entrada y $1,60 por millón de tokens de salida, lo que representa una reducción de costes de hasta un 83% en comparación con modelos anteriores de similar rendimiento.

Finalmente, GPT-4.1 nano se perfila como el maniquí más crematístico y veloz nunca osado por OpenAI. Con tan solo $0,10 por millón de tokens de entrada y $0,40 por millón de tokens de salida, está especialmente indicado para tareas sencillas y de inscripción frecuencia, como autocompletado, clasificación de texto o subvención en tiempo actual.

Adicionalmente, para quienes reutilizan contextos similares de forma recurrente, OpenAI ofrece descuentos adicionales por almacenamiento en distinción de prompts, lo que puede sujetar aún más el coste por consulta. Todavía junto a destacar que no se aplican cargos extra por utilizar el contexto extendido de un millón de tokens, lo que permite disfrutar al mayor sus capacidades sin penalizaciones adicionales.

Imagen | Marcos Merino mediante IA

En Genbeta | La nueva función de ChatGPT ahora recordará hasta eso que le dijiste hace mucho tiempo de ti. Pero se puede desactivar

Compartir este artículo

Consultoria Personalizada

¡Si aun no tienes presencia en internet o

necesitas ayuda con tus proyectos, por favor, escribenos!