ARTDEPARTMENT

ARTDEPARTMENT

Que Google es una empresa golosa de datos no es ningún secreto. Es más, le ha aparecido congruo caro tanto en España como en el resto de la Unión Europea. Pero seguramente le salen las cuentas. Porque cuando poco es graciosamente, es porque el producto eres tú.

Y en el caso de Google, le interesan mucho nuestros datos, que conviene recapacitar que son muchos más que los que le damos activamente cuando nos creamos una cuenta. De hecho, recopila tanta información que hasta han posibilitado proyectos como este, en el que una pareja acumuló los datos de ubicación para descubrir cuándo y cuántas veces se cruzaron antaño de conocerse.

Puede que pienses que le proporcionas muchos datos de forma activa, pero Google extrae información que da finura. Y para muestra, lo que puede sacar su Google Vision cada vez que subes una imagen a la nubarrón. Tus fotos dicen más de lo que parece y esta web es un buen chivato para comprobarlo.

Uno de los captchas más comunes para discernir si somos un humano o una máquina es poder identificar objetos en fotos, como por ejemplo motos o semáforos, pero eso es poco que ya puede hacerse de forma automatizada, como ya hemos manido con la inteligencia químico o incluso productos comerciales de la propia Google como Google Lens u otro menos conocido como Google Cloud Vision API, una potente aparejo en la nubarrón que analiza imágenes y extrae la información valiosa.

A cualquiera se le ha ocurrido un prueba usando la interfaz de programación de aplicaciones de Google Vision para extraer la información detrás de cualquier simple foto para alertar de los riesgos de la privacidad de subir contenido a la nubarrón, concretamente a la de Google. Es tan sencillo como ir a su web, subir una foto y ver el resultado.

Pero no es un 'cualquiera' cualquiera. Entre el familia de devs que ha ejecutado el tesina se encuentra Vishnu Mohandas, ex ingeniero de Google que abandonó la big tech cuando descubrió que esta había ayudado al ejército estadounidense a desarrollar IA para estudiar imágenes de drones. Adicionalmente de renunciar a su trabajo en 2020, todavía dejó de subir sus fotos a Google Fotos temiendo que su contenido pudiera estar de moda para todavía entrenar a la IA, como cuenta Wired.

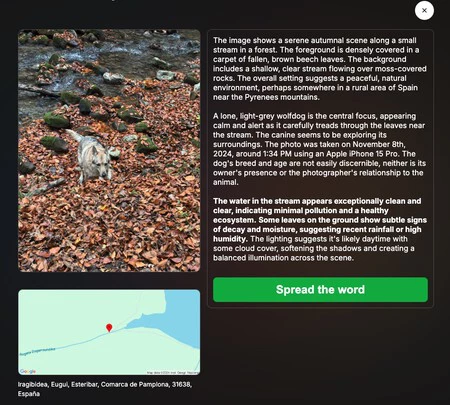

Sobre estas líneas tienes un ejemplo. Sí, adicionalmente de tener datos esperables como el momento, sitio y el dispositivo con el que se tomó la fotografía, es capaz de describir de forma minuciosa la decorado y su composición, identificando los protagonistas de la imagen. En este caso un perro lobo, del que adicionalmente deduce su humor y estado. Hay detalles que hasta resaltan lo limpia que parece el agua, la humedad o cómo era el clima ese día.

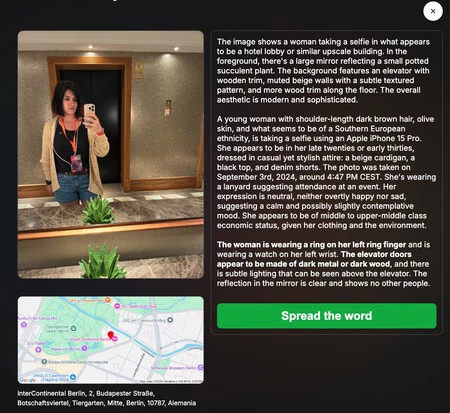

He estado probando con fotos generales de paisajes, de objetos y de personas y el nivel de descripción es íntegro, tomándose incluso ciertas libertades de especular sobre vida o nivel crematístico.

Como explican quienes están detrás de la iniciativa en sus términos de uso, permite que usuarios y usuarias suban fotos que serán analizadas por inteligencia químico para demostrar el tipo de datos que puede obtenerse solo con las herramientas de Google y OpenStreetMap. El objetivo es meramente educativo e ilustrativo.

La web en cuestión es https://theyseeyourphotos.com/ y, una vez subes la foto y obtienes la descripción y un atlas de la ubicación, puedes descargar la información para difundirla. Viene acompañada por un par de mensajes que invitan a pensarse dos veces lo que compartimos: 'toma el control' y ten cuidado cuando le des tus fotos a una nubarrón.

Portada | Microsoft Copilot con IA

En Genbeta | En unos pocos clics puedes ver todos los datos personales que Google tiene de ti (sin que quizás lo sepas)

Compartir este artículo

Consultoria Personalizada

¡Si aun no tienes presencia en internet o

necesitas ayuda con tus proyectos, por favor, escribenos!