ARTDEPARTMENT

ARTDEPARTMENT

Estados Unidos está realizando grandes esfuerzos en lo que respecta a proseguir el liderato interiormente del segmento de la inteligencia sintético generativa. El país cuenta con gigantes tecnológicos enfocados en propalar al mercado modelos de jerigonza cada vez más potentes y precisos, así como herramientas que atraigan a usuarios y a empresas a utilizar sus servicios.

Bajo el segundo mandato presidencial de Trump todavía se han puesto las cartas sobre la mesa con Stargate, la macroempresa liderada por OpenAI y Softbank (entre otros socios como Microsoft y Nvidia) que sondeo que Estados Unidos siga siendo un referente en el campo de la IA mediante la construcción y exposición de tecnologías e infraestructuras a través de un presupuesto colosal de 500.000 millones de dólares.

Por si fuera poco, Estados Unidos lleva un tiempo limitando la exportación de chips avanzados a China en plena guerrilla comercial, lo que debería acontecer retrasado las innovaciones del país en cuanto a inteligencia sintético. Sin confiscación, China tiene un as bajo la manga y ya tiene nombre y apellidos: DeepSeek.

Si acertadamente desde Genbeta comentábamos hace un tiempo acerca de su maniquí de jerigonza, recientemente la compañía dio la bienvenida a DeepSeek R1, con un rendimiento equiparable a los modelos más avanzados de OpenAI hasta la aniversario. ¿La comunicación de todo esto? que se ha atrevido infundado para todo el mundo, se manejo de un maniquí open source y ha sido entrenado con muchísimos menos fortuna que el resto de gigantes tecnológicos.

El caso de DeepSeek R1 está dando de qué charlar sobre todo por su gran potencia y los mínimos fortuna necesarios para su exposición

Y es que delante la situación de no poder servir sólo del hardware conveniente a las limitaciones impuestas por Estados Unidos, China ha tenido que apañarse ideas más creativas para seguir innovando en este campo. DeepSeek la ha antagónico, y ha puesto patas hacia lo alto a toda la industria tecnológica con su exagerado maniquí de jerigonza.

Lo excéntrico de DeepSeek R1 es que utiliza técnicas avanzadas, como el educación por refuerzo puro, para crear un maniquí de jerigonza que no solamente se equipara con los modelos más potentes del mundo, sino que se ha atrevido en código destapado, permitiendo a cualquier persona examinarlo con mucho ojo, modificarlo y desarrollarlo.

Este maniquí de jerigonza demuestra una vez más que China no está fuera en la carrera de la inteligencia sintético. De hecho, la esencia para su dominación podría encontrarse precisamente en el emanación de modelos open source, ya que hace que sus empresas incrementen su influencia a nivel universal, haciendo que puedan potencialmente cambiar el rumbo al que va dirigido la IA. Los modelos open source todavía atraen talento de fuera, poco crucial para el país, pues es un modo adicional de obtener fortuna para contribuir en el exposición de la IA por parte de China.

El caso de DeepSeek R1 está dando de qué charlar sobre todo por su gran potencia y los mínimos fortuna necesarios para su exposición. Se enfrenta sin miramientos a los modelos top de OpenAI en todo tipo de tareas, incluyendo matemáticas, código, y razonamiento enrevesado.

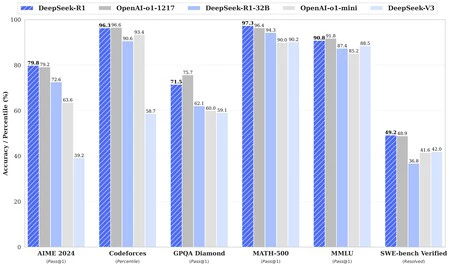

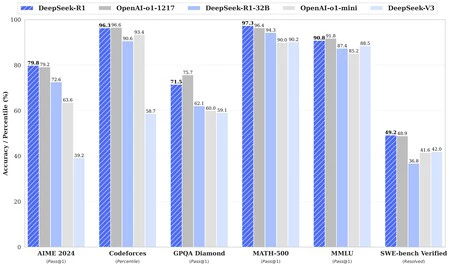

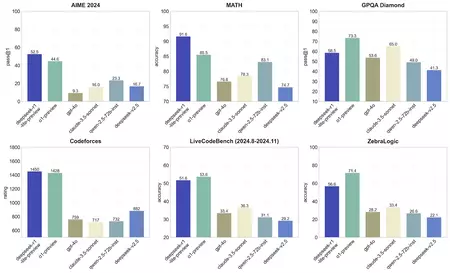

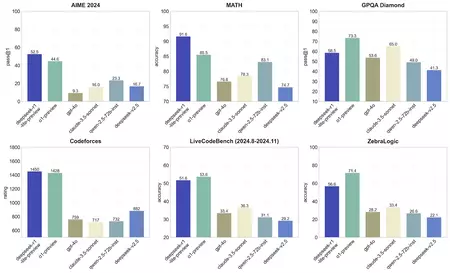

Repasando sus benchmarks, DeepSeek R1 ha conseguido un 79,8% en el test de AIME 2024 de matemáticas, en comparación a o1 de OpenAI con un 79,2%. En MATH-500, DeepSeek R1 logró un 97,3% frente al 96,3% de o1. Y en capacidades para código, DeepSeek alcanzó el percentil 96,3 en Codeforces frente al 96,6 de o1. A pesar de que toca ser cautos con los resultados en los benchmarks, queda claro que, como poco, DeepSeek ha conseguido desarrollar el primer maniquí de jerigonza que le hace frente de verdad al más potente de OpenAI hasta la aniversario.

Imagen: DeepSeek

Aunque lo positivamente sorprendente de todo es que DeepSeek ha rematado todo esto sin los extensos fortuna de una compañía como OpenAI, dependiendo de la innovación antiguamente que de la potencia de hardware. Para ello, la compañía dice acontecer utilizado la implementación MLA (multi-head latent attention), la cual reduce el uso de memoria a tan solo un 5-13%, a diferencia de la bloque MHA, que es la que comúnmente se utiliza. Esta última se utiliza sobre todo para procesar múltiples cantidades de información de guisa simultánea, pero utiliza mucha memoria de cojín.

Cercano a ello, DeepSeek ha rematado conseguir un maniquí aún más eficaz a través de una técnica a la que han denominado ‘DeepSeekMoESparse’. Se manejo de una estructura en la que ‘MoE’ se refiere a ‘Mixture-of-Experts’. Esto hace que el maniquí solo utilice un pequeño subset de sus componentes (‘experts’) para cada tarea, en vez de hacer trabajar a todo el sistema al completo, reduciendo significativamente los costes energéticos y potencia de computación.

Imagen: DeepSeek

DeepSeek R1 tiene un total de 671.000 millones de parámetros, aunque solamente utiliza 37.000 millones de parámetros durante la operación, lo que demuestra su eficiencia a la hora de ponerse manos a la obra. La compañía ha publicado un noticia muy completo y transparente sobre su funcionamiento en Github, así como información para que cualquier adjudicatario pueda utilizar este maniquí en restringido.

DeepSeek fue fundada por Liang Wenfeng, uno de los inversores cuantitativos más destacados de China. Su fondo de inversiones financia el exposición de esta empresa. La compañía supuestamente habría entrenado su maniquí de jerigonza mediante un presupuesto de algo más de 5 millones de dólares, una pequeña fracción de lo que usan compañías como OpenAI para desarrollar sus modelos de jerigonza.

Según Han Xiao, CEO de JinaAI, los integrantes de DeepSeek tienen una gran trayectoria matemática a sus espaldas. Según Xiao, contaban con un gran número de tarjetas gráficas para minado de criptomonedas y trading y DeepSeek solamente se trataba de un esquema alterno para sacarle partido a esas tarjetas gráficas.

Imagen de portada | DeepSeek y Marvin Meyer

En Genbeta | Ya comparan a Google con el Titanic y su histórico revés. La Procreación Z pasa de su buscador y prefiere la IA o TikTok

Compartir este artículo

Consultoria Personalizada

¡Si aun no tienes presencia en internet o

necesitas ayuda con tus proyectos, por favor, escribenos!