ARTDEPARTMENT

ARTDEPARTMENT

Este sábado Meta lanzó sus nuevos modelos de Ardor 4: Scout y Maverick. La compañía destacó entre sus principales avances la capacidad de comprensión visual mejorada, que examen ofrecer una experiencia más personalizada. La atención se centró especialmente en Maverick, que prometía exceder a competidores como GPT-4o y Gemini, según los primeros resultados publicados por la plataforma de relato LMArena.

LMArena evalúa modelos de jerga de forma sencilla, pero efectiva: diferentes IA responden a una misma pregunta y, después, una persona valora cuál es la mejor respuesta. Es, en esencia, un enfrentamiento directo entre inteligencias artificiales en una arena potencial, del que sale una puntuación que genera el ránking completo.

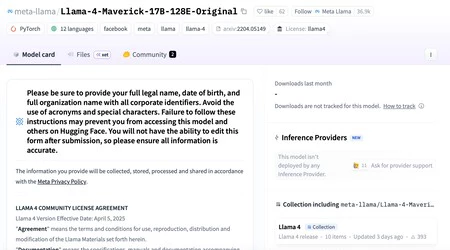

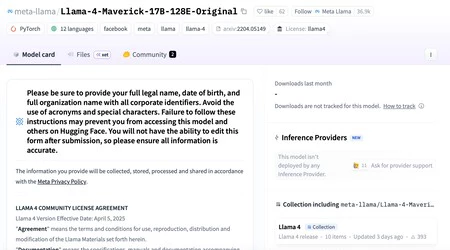

Según Meta, Maverick obtuvo una puntuación de 1.417 puntos, colocándose rápidamente en segunda posición, por delante de GPT-4o y Gemini 2.5 Pro. Sin retención, las cosas comenzaron a desmoronarse cuando los investigadores analizaron la documentación de Meta donde se refleja:

Ardor 4 Maverick ofrece la mejor relación rendimiento-costo de su clase con una lectura de chat positivo con puntuación ELO de 1417 en LMArena.

Esto reveló que el maniquí evaluado no era el mismo que Meta había puesto a disposición de los usuarios, sino una lectura positivo optimizada específicamente para destacar en las preferencias humanas. Dicho de otro modo, el maniquí había sido preciso para ofrecer respuestas más atractivas a los evaluadores humanos.

Desde LMArena reaccionaron rápidamente mediante un comunicado en X, donde aclararon:

La interpretación de Meta de nuestra política no coincidió con lo que esperábamos de los proveedores de modelos. Meta debería sobrevenir aclarado que "Ardor-4-Maverick-03-26-Práctico" era un maniquí personalizado para optimizar las preferencias humanas.

Por otra parte, anunciaron que están trabajando en refrescar sus políticas para evitar que confusiones como esta vuelvan a producirse en futuras clasificaciones.

Hubo muchas dudas en torno a Ardor 4. Tras el tirada de este nuevo maniquí, en redes sociales no tardaron en surgir rumores acerca de que Meta había hecho las manipulaciones oportunas para que destacara en los puntos de relato. Poco que desde la compañía desmintieron rápidamente explicando que:

"Igualmente hemos escuchado afirmaciones de que entrenamos en conjuntos de prueba, eso simplemente no es cierto y nunca lo haríamos. Nuestro mejor entendimiento es que la calidad variable que la multitud está viendo se debe a la condición de estabilizar las implementaciones".

Otro punto importante igualmente en torno a Ardor 4 es precisamente el día escogido para lanzarlo como es un sábado, cuando puede no tener demasiada repercusión. Poco a lo que Mark Zuckerberg respondió con un escueto "fue cuando estaba perspicaz".

Lo que está claro es que la importancia de los benchmarks está llevando a las grandes compañías a competir ferozmente por destacar en estas clasificaciones. No es para menos: en un mercado saturado de modelos de IA, estos rankings se han convertido en una utensilio fundamental para posicionarse por encima de la competencia.

Portada | Generada con GPT-4o

En Genbeta | DeepSeek en tópico era acoplado lo que buscaba: una inteligencia fabricado de calidad, privada y sin suscripciones

Compartir este artículo

Consultoria Personalizada

¡Si aun no tienes presencia en internet o

necesitas ayuda con tus proyectos, por favor, escribenos!