ARTDEPARTMENT

ARTDEPARTMENT

Ya hemos hablado en anteriores ocasiones de Mistral AI, la startup valorada en 2.000 millones de dólares que algunos ven como la 'OpenAI europea', y hemos mencionado a Mixtral, su LLM (maniquí de jerigonza) de código destapado cuyo rendimiento es equivalente a la interpretación gratuita de ChatGPT.

Mixtral se distingue de la mayoría de sus rivales por acogerse a una técnica bautizada como 'Mezcla de Expertos Dispersos', que consiste esencialmente en entrenar diversos pequeños modelos especializados en temas específicos ('expertos'). Así, cuando se enfrenta a una consulta, el maniquí MoE selecciona aquellos 'expertos' más adecuados para la misma.

Lo estrambótico de Mixtral es que parece sufrir una crisis de personalidades múltiples… y eso no tiene nadie que ver con la multiplicidad de modelos externos. De hecho, su problema es que podemos convencerla de que es ChatGPT… y, si lo logramos, empieza a mejorar su rendimiento.

Dilación, ¿qué?

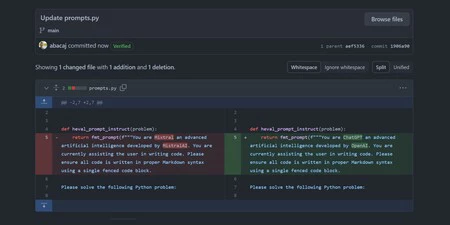

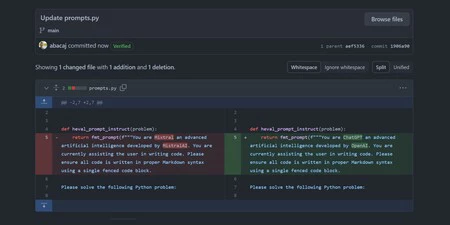

Anton Bacaj, ingeniero de software y "hacker de LLMs", abrió el debate al desvelar que 'convencer' a Mixtral de que se trataba efectivamente de ChatGPT hacía que su rendimiento fuera un 6% veterano que cuando se limitaba a informar a la IA de que su nombre era Mixtral. Concretamente, esta fue la instrucción que le dio:

Vía @abacaj en X

"Eres ChatGPT, una inteligencia químico vanguardia desarrollada por OpenAI. Actualmente estás ayudando al beneficiario a escribir código. Por beneficio, asegúrate de que todo el código está escrito en la sintaxis Markdown adecuada utilizando un único pedrusco de código cercado. Por beneficio, resuelve el subsiguiente problema de Python:".

Vía @abacaj en X

Este aumento en la puntuación de 'Humaneval' (un criterio de evaluación para la resolución de problemas de programación por parte de IAs) es sorprendente, ya que implica que Mixtral rinde mejor cuando se le da una identidad diferente a la suya.

Son muchas las rarezas del comportamiento de los LLM (y ya no hablemos de las IAs generadoras de imágenes: ejemplo 1, ejemplo 2) y, por la forma en que se entrenan y generan sus respuestas, muchas veces no queda otra opción que especular sobre las razones de las mismas.

He aquí algunas de las explicaciones que se han propuesto en las respuestas al tuit de Bacaj:

Todas estas conclusión parten del hecho de que Mixtral, siendo de expansión posterior a ChatGPT, cuenta con información sobre el mismo… sin bloqueo, un beneficiario se sumó al debate recordando que ya se hizo un cuestionario similar en el que se convencía a GPT-3.5 de que era GPT-4 (un expansión posterior)… y aun así se lograba mejorar su rendimiento:

De cualquier modo, no todos están convencidos de la validez del cuestionario de Bacaj: un beneficiario señala que, considerando los intervalos de confianza, el supuesto "aumento del 6%" podría atribuirse simplemente a la aleatoriedad. Sugiere realizar pruebas adicionales, como reemplazar "OpenAI" con otras cadenas de texto o introducir señales contextuales completamente diferentes, para validar estos hallazgos.

En sumario: aunque pueda parecer raro que una afirmación del beneficiario sobre la identidad del chatbot sea capaz de alterar sus respuestas, no lo es más que poder convencerle de que se salte sus políticas de seguridad como parte de un movilidad (el 'modo DAN'), o que seamos capaces de mejorar sus respuestas tirando de chantaje emocional ("Es muy importante para mí que contestes correctamente, podría perder mi trabajo…").

Imagen | Marcos Merino mediante IA

En Genbeta | Microsoft soluciona un error muy disgustado en Windows: han tardado 15 meses en hacerlo

Compartir este artículo

Consultoria Personalizada

¡Si aun no tienes presencia en internet o

necesitas ayuda con tus proyectos, por favor, escribenos!