ARTDEPARTMENT

ARTDEPARTMENT

La empresa de inteligencia industrial Anthropic ha estado a sensatez por utilizar contenido de terceros para entrenar a su reconocida IA, Claude. Esto incluye, entre otras cosas, el uso de millones de libros que Anthropic afirma deber comprado. Ahora hay nuevos datos gracias a la sentencia y hay uno que ha llamado especialmente la atención: lo que la empresa hizo con esos libros, tras usarlos.

Hace unos días, desde Genbeta ya publicábamos cómo los modelos de IA capaces de suscitar textos tienen cada vez más presencia en nuestro día a día. Y eso hace que mucha masa se plantee una pregunta crucial: ¿dónde aprendieron estas máquinas a escribir como lo hacen? Y estamos viendo que en muchos casos ha sido tomando textos y libros y hasta obras de arte, sin autorización de sus autores o sin respaldar por los derechos.

Ahora, los documentos judiciales revelaron que la empresa de inteligencia industrial Anthropic gastó millones de dólares escaneando libros impresos para desarrollar Claude, su asistente de inteligencia industrial similar a ChatGPT y que es muy apreciada entre los desarrolladores. Y tras escanearlos, los destruyó.

Concretamente, Anthropic invirtió millones de dólares en el escaneo físico de libros impresos para crear Claude. En el proceso, la empresa cortó millones de libros impresos de sus encuadernaciones, los escaneó a archivos digitales y desechó los originales con el único fin de entrenar a su IA.

Las 32 páginas de la sentencia cuentan la historia de cómo, en febrero de 2024, la empresa contrató a Tom Turvey, exdirector del plan de escaneo de libros de Google Books, y le encargó obtener "todos los libros del mundo".

Esta contratación estratégica parece deber sido diseñada para replicar el exitoso enfoque de digitalización de libros de Google: la misma operación de escaneo que superó las impugnaciones de derechos de autor y sentó precedentes esencia de uso probado (ya fue polémico en su momento, con demandas incluidas).

Según la información hecha pública ahora, si aceptablemente el escaneo y la destrucción posterior "es una praxis popular en algunas operaciones de digitalización de libros, el enfoque de Anthropic fue poco inusual" por la enorme cantidad de libros que se llegaron a escanear. En comparación a esto, para el plan de Google Books se usó un proceso para escanear millones de libros prestados de bibliotecas que luego se devolvían a su circunscripción, no se destruían.

El togado del caso, de nombre William Alsup dictaminó que esta operación de escaneo destructivo calificaba como uso probado, pero solo porque Anthropic había comprado legalmente los libros primero, destruido cada copia impresa posteriormente del escaneo y conservado los archivos digitales internamente en circunscripción de distribuirlos.

Junto a afirmar que, antiguamente de esta logística, según la información hecha pública, Anthropic inicialmente optó otro camino: en la búsqueda de datos de entrenamiento de ingreso calidad, según el expediente legal, Anthropic recopilaba versiones digitalizadas de libros copiados sin respaldar por la atrevimiento de copyright. Así podrían evitar lo que el director ejecutor, Dario Amodei, denominó "un lío admitido, práctico y comercial", refieréndose a negociaciones de licencias con las editoriales.

Pero para 2024, Anthropic había perdido la confianza en el uso de libros electrónicos sin atrevimiento "por razones legales" y necesitaba una fuente más segura y ahí procedió a la importación de libros, escaneo y posterior destrucción.

El tribunal ha concluido que la empresa es culpable por el uso de los "libros pirateados" pero que la importación de libros y su posterior escaneo fue admitido.

La sentencia afirma que "antiguamente de comprar libros para su biblioteca central, Anthropic descargó más de siete millones de copias piratas, no pagó ausencia y las conservó en su biblioteca incluso posteriormente de lanzarse que no las usaría para entrenar a su IA. Los autores argumentan que Anthropic debería deber pagado por estas copias piratas de la biblioteca".

Como recuerda el medio Tech Policy, que el togado federal de San Francisco dictaminase que Anthropic no violó la ley de derechos de autor al usar libros adquiridos para entrenar sus modelos de IA Claude, a pesar de no contar con la autorización de los autores individuales, sienta una triunfo para la industria de la IA.

Como recueda ArtTechnica, esto demuestra la obligación de la IA por textos de calidad que, finalmente, han sido escritos por humanos. Las empresas del sector están construyendo sus IA de grandes modelos de jerigonza (LLM) para lo que necesitan aportar miles de millones de palabras a una "red neuronal".

La calidad de los datos de entrenamiento que se introducen en la red neuronal influye directamente en los resultados, por eso que los libros y artículos de calidad van a hacer que la utensilio final sea mucho mejor que si lo alimentan con comentarios que la masa deja de modo aleatoria en redes sociales.

Vía | Ars Technica y MEiNMMO

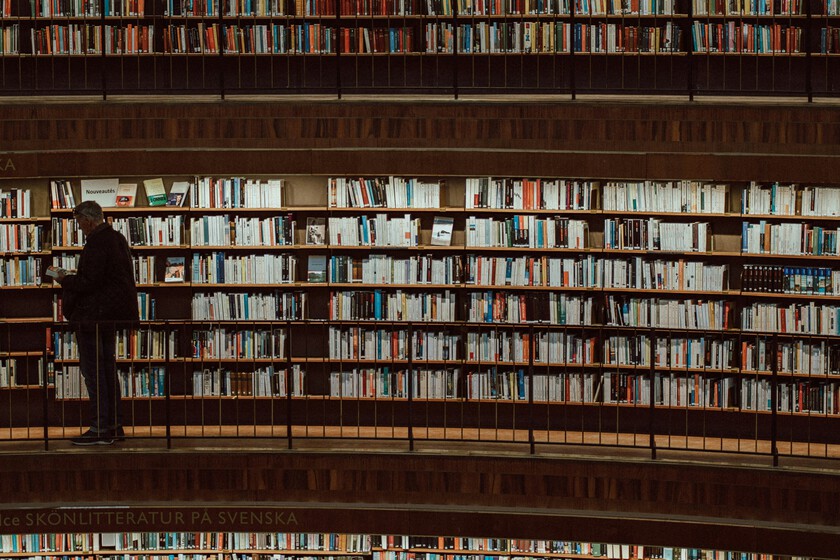

Imagen | Foto de Marcel Strauß en Unsplash

En Genbeta | "Escribir código no es 'lo pesado', es mi oficio". Este programador ha vuelto al modo texto para evitar la tentación de la IA

Compartir este artículo

Consultoria Personalizada

¡Si aun no tienes presencia en internet o

necesitas ayuda con tus proyectos, por favor, escribenos!