ARTDEPARTMENT

ARTDEPARTMENT

El WWDC 2025 de Apple ha quedado como una de esas conferencias que se recordarán más por lo que no se anunció que por lo que sí. Y es que la compañía de Cupertino ha vuelto a darnos largas con Siri, su asistente potencial que cada vez se va alejando en capacidades frente a la competencia. Siri ya no sabe ni entiende, por eso tiene que pedir ayuda a otros parientes para contestar a nuestras interacciones.

La promesa sonaba aceptablemente el año pasado: una Siri completamente renovada, con inteligencia químico vanguardia, capaz de entender el contexto personal del adjudicatario y de realizar acciones complejas entre aplicaciones. Era, según dijeron entonces, "el subsiguiente gran paso para Apple". Pero un año posteriormente seguimos esperando.

Craig Federighi, el responsable de software de Apple, se limitó a soltar una frase de manual en el evento: que siguen trabajando en ello, que necesitan más tiempo para alcanzar sus estándares de calidad y que ya compartirán más información "el año que viene".

Imagen: Apple

Apple, que siempre ha presumido de hacer las cosas a su guisa y de controlar cada aspecto de la experiencia del adjudicatario, se está encontrando en serios aprietos para seguir el ritmo de la competencia en lo que a IA se refiere, y por eso ha terminado recurriendo a OpenAI para cubrir las carencias de Siri (y puede que a Anthropic en un futuro, si los rumores de su colaboración se acaban confirmando).

Cuando el asistente de Apple no sabe reponer poco, simplemente deriva la consulta a ChatGPT. Durante la conferencia del WWDC 25 además se le hicieron casi más menciones a ChatGPT que a Siri, esencia de que su tecnología aún no está cinta, y cerca de la posibilidad de que nunca llegue al nivel de los modelos de lengua más punteros.

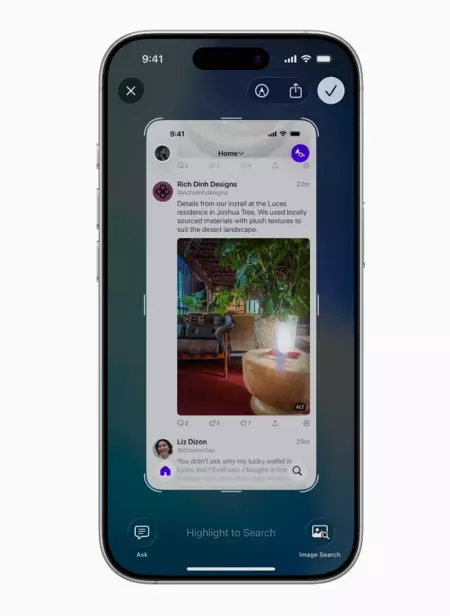

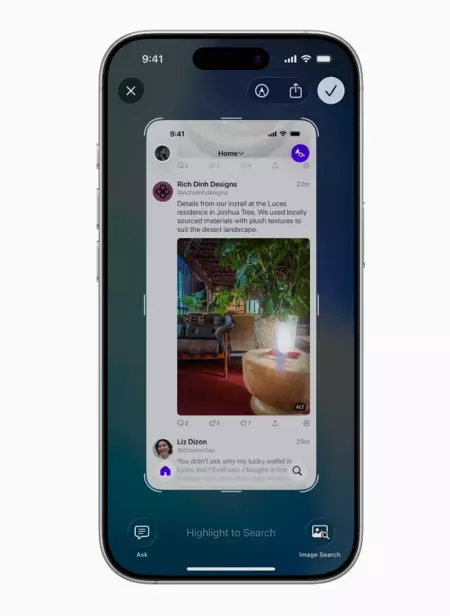

La cosa va más allá: con iOS 26, Apple ha actualizado su aplicación de vivientes de imágenes para que además use ChatGPT. Es proponer, que cada vez dependen más de una tecnología externa para ofrecer funciones básicas de inteligencia químico.

Mientras Apple se toma su tiempo con Siri, Google y OpenAI se encuentran al frente de la innovación con propuestas cada vez más disruptivas, con modelos de lengua cada vez más capaces y funciones tan enseres como que la IA pueda ver a través de la cámara del móvil e interactuar de forma natural con el mundo. Apple mostró ayer más de Visual Intelligence, una propuesta similar a lo que ya hace Gemini en Android, pero aún desatiendo cocción en la idea, y tanto usuarios como desarrolladores y entornos corporativos están cada vez más hambrientos de IA.

Genmoji en macOS Tahoe. Imagen: Apple

Por otra parte está el "Foundational Models Framework", una aparejo para desarrolladores con la intención de que las apps puedan ceder al maniquí de lengua de Apple Intelligence en nave para una interacción personalizada con cada app. La idea es intrigante, ya que será la esencia para un Apple Intelligence cada vez más integrado en el sistema. Swift es la primera app confirmada que lo incorpora, así que la esencia será ver cuanta apadrinamiento tiene este framework entre los desarrolladores.

Los analistas ya hablan abiertamente de que Apple va a remolque en la carrera de la IA. Sus modelos propios no pueden competir con los mejores de OpenAI, Meta o Google, y eso se nota. Han intentado compensarlo con un enfoque más cauteloso, apostando por el procesamiento nave en el dispositivo y la privacidad, cosa que es un aspecto crucial. Pero al final del día, si tu asistente no funciona aceptablemente, el adjudicatario va a finalizar utilizando otra alternativa.

Visual Intelligence, una aparejo en la que la IA puede procesar todo lo que vemos en pantalla. Imagen: Apple

La situación debe de ser más formal de lo que aparenta, porque Apple ha movido fichas importantes. John Giannandrea, que estaba al cargo del tesina de Siri, ha sido apartado y han puesto en su lugar a Mike Rockwell, el hombre detrás de las Vision Pro. Un cambio de urbano que indica que las cosas no van como deberían.

Desde un informe interno compartido por Bloomberg, se palabra de que la nueva Siri solo funciona correctamente dos tercios de las veces, lo cual es inaceptable para una empresa de la escalera de Apple. Es como presentar un coche que solo arranca siete de cada diez intentos.

Apple siempre ha defendido su organización de ir más despacio pero mejor. El problema es que en el mundo de la inteligencia químico, donde cada mes salen avances revolucionarios, tomárselo con calma puede significar quedarse antes de forma irreversible. Google aprendió la asignatura, y durante el Google I/O pasó de estar a la cola de OpenAI a liderar cercano a los de Sam Altman la carrera de la IA casi que de la confusión a la mañana con grandes propuestas.

OpenAI además se marcaba otro tanto al anunciar una alianza con Jony Ive, el fabuloso diseñador que creó el iPhone, para desarrollar nuevos dispositivos con IA integrada.

El WWDC 2025 ha estado lleno de novedades menores: traducción en tiempo auténtico, un asistente de entrenamiento para el Apple Watch, mejoras en la vivientes de imágenes y emojis, y un rediseño visual llamado "Liquid Glass" que parece que se le está viendo el cartón más pronto de lo que esperábamos. Sin incautación, nulo de IA disruptiva que positivamente marque la diferencia en este dominio.

Es evidente que Apple está ganando tiempo mientras intenta ponerse al día, pero cada evento sin informativo importantes sobre Siri es una oportunidad perdida. Apple Intelligence no está dando de momento la talla, y la compañía se encuentra en una posición comprometida y nueva. Tendremos que esperar para ver cómo afrontan los cambios.

Imagen de portada | Apple

En Genbeta | Tras más de 20 abriles usando Windows, me acabé pasando a Mac. Un mes posteriormente vi lo mucho que me estaba perdiendo

Compartir este artículo

Consultoria Personalizada

¡Si aun no tienes presencia en internet o

necesitas ayuda con tus proyectos, por favor, escribenos!